Per soddisfare le esigenze dei servizi cloud, la rete viene gradualmente suddivisa in Underlay e Overlay. La rete Underlay è costituita da apparecchiature fisiche come routing e switching nei data center tradizionali, che si basano ancora sul concetto di stabilità e forniscono capacità di trasmissione dati di rete affidabili. Overlay è la rete aziendale incapsulata su di essa, più vicina al servizio, tramite l'incapsulamento del protocollo VXLAN o GRE, per fornire agli utenti servizi di rete facili da usare. La rete Underlay e la rete Overlay sono correlate e disaccoppiate, e possono evolversi in modo indipendente.

La rete sottostante è il fondamento della rete. Se la rete sottostante è instabile, non esiste alcun SLA per l'azienda. Dopo l'architettura di rete a tre livelli e l'architettura di rete Fat-Tree, l'architettura di rete del data center sta passando all'architettura Spine-Leaf, che ha inaugurato la terza applicazione del modello di rete CLOS.

Architettura di rete tradizionale del data center

Design a tre strati

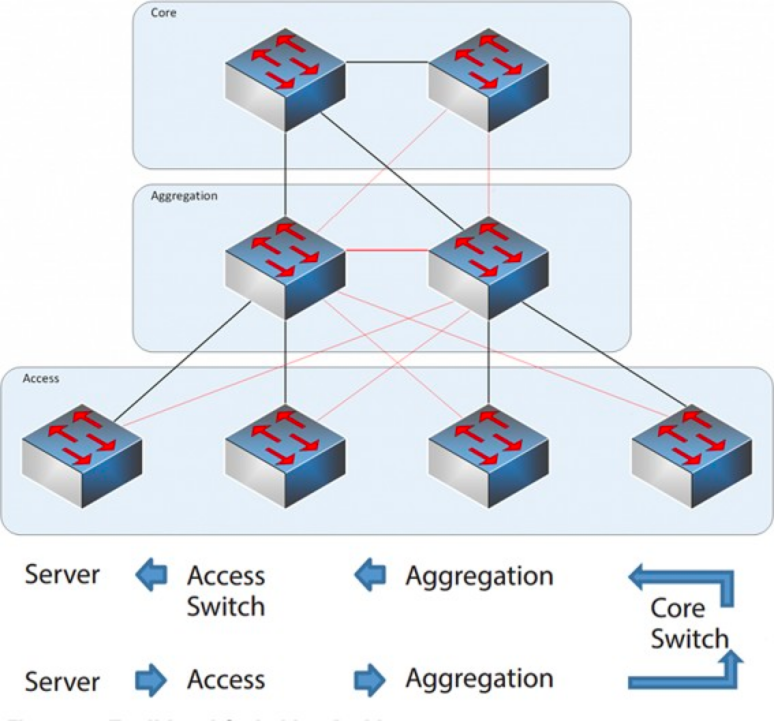

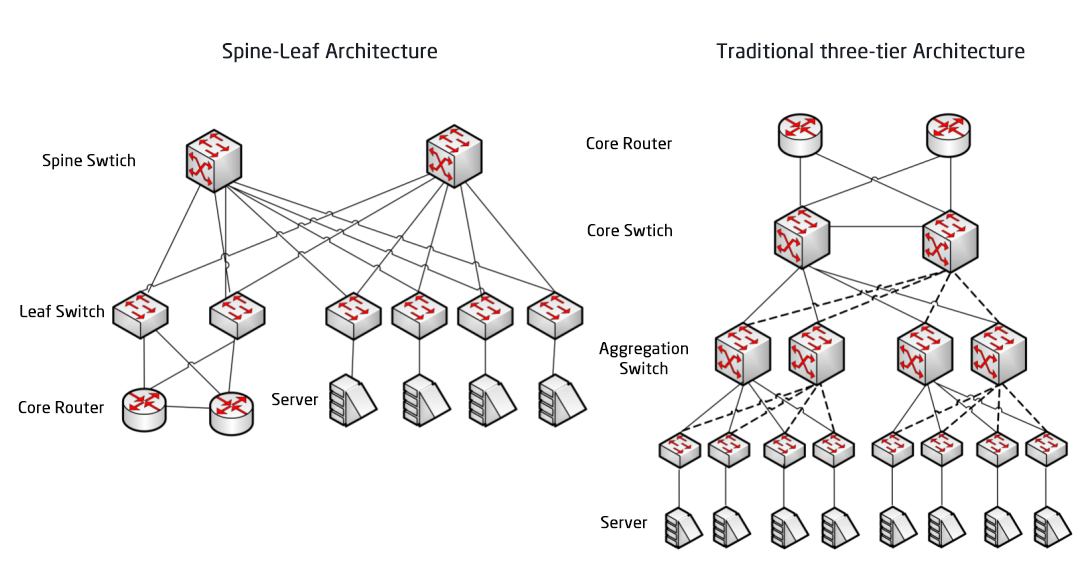

Dal 2004 al 2007, l'architettura di rete a tre livelli era molto diffusa nei data center. Si compone di tre livelli: il livello core (la dorsale di commutazione ad alta velocità della rete), il livello di aggregazione (che fornisce connettività basata su policy) e il livello di accesso (che collega le workstation alla rete). Il modello è il seguente:

Architettura di rete a tre livelli

Livello core: gli switch core garantiscono l'inoltro ad alta velocità dei pacchetti in entrata e in uscita dal data center, la connettività ai diversi livelli di aggregazione e una rete di routing L3 resiliente che in genere serve l'intera rete.

Livello di aggregazione: lo switch di aggregazione si connette allo switch di accesso e fornisce altri servizi, quali firewall, offload SSL, rilevamento delle intrusioni, analisi di rete, ecc.

Livello di accesso: gli switch di accesso si trovano solitamente nella parte superiore del rack, per questo sono anche chiamati switch ToR (Top of Rack) e si collegano fisicamente ai server.

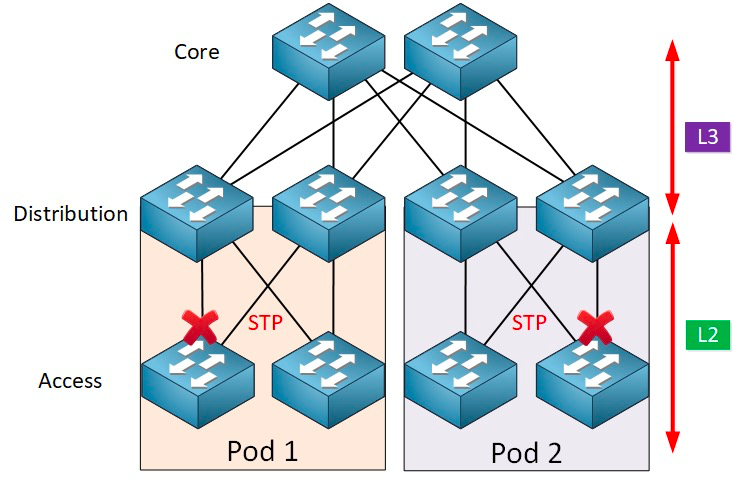

In genere, lo switch di aggregazione è il punto di demarcazione tra le reti L2 e L3: la rete L2 si trova al di sotto dello switch di aggregazione e la rete L3 si trova al di sopra. Ogni gruppo di switch di aggregazione gestisce un Point Of Delivery (POD) e ogni POD è una rete VLAN indipendente.

Protocollo Network Loop e Spanning Tree

La formazione di loop è causata principalmente dalla confusione causata da percorsi di destinazione poco chiari. Quando gli utenti costruiscono reti, per garantire l'affidabilità, di solito utilizzano dispositivi e collegamenti ridondanti, quindi si formano inevitabilmente dei loop. La rete di livello 2 si trova nello stesso dominio di broadcast e i pacchetti broadcast vengono trasmessi ripetutamente nel loop, formando una tempesta di broadcast, che può causare il blocco delle porte e la paralisi delle apparecchiature in un istante. Pertanto, per prevenire le tempeste di broadcast, è necessario impedire la formazione di loop.

Per prevenire la formazione di loop e garantire l'affidabilità, è possibile trasformare i dispositivi e i collegamenti ridondanti solo in dispositivi e collegamenti di backup. Ciò significa che le porte e i collegamenti dei dispositivi ridondanti sono bloccati in circostanze normali e non partecipano all'inoltro dei pacchetti dati. Solo in caso di guasto del dispositivo, della porta o del collegamento di inoltro corrente, con conseguente congestione della rete, le porte e i collegamenti dei dispositivi ridondanti vengono aperti, in modo che la rete possa essere ripristinata alla normalità. Questo controllo automatico è implementato dal protocollo Spanning Tree (STP).

Il protocollo spanning tree opera tra il livello di accesso e il livello di sink e al suo interno si basa su un algoritmo spanning tree in esecuzione su ogni bridge abilitato STP, specificamente progettato per evitare loop di bridging in presenza di percorsi ridondanti. STP seleziona il percorso dati migliore per l'inoltro dei messaggi e non consente i collegamenti che non fanno parte dello spanning tree, lasciando attivo un solo percorso tra due nodi di rete qualsiasi, mentre l'altro uplink verrà bloccato.

STP offre numerosi vantaggi: è semplice, plug-and-play e richiede pochissima configurazione. Le macchine all'interno di ciascun pod appartengono alla stessa VLAN, quindi il server può migrare la posizione in modo arbitrario all'interno del pod senza modificare l'indirizzo IP e il gateway.

Tuttavia, i percorsi di inoltro paralleli non possono essere utilizzati da STP, che disabiliterà sempre i percorsi ridondanti all'interno della VLAN. Svantaggi di STP:

1. Lenta convergenza della topologia. Quando la topologia della rete cambia, il protocollo spanning tree impiega 50-52 secondi per completare la convergenza della topologia.

2. Non può fornire la funzione di bilanciamento del carico. Quando si verifica un loop nella rete, il protocollo spanning tree può semplicemente bloccarlo, impedendo al collegamento di inoltrare pacchetti di dati, sprecando risorse di rete.

Virtualizzazione e sfide del traffico est-ovest

Dopo il 2010, al fine di migliorare l'utilizzo delle risorse di elaborazione e archiviazione, i data center hanno iniziato ad adottare la tecnologia di virtualizzazione e un gran numero di macchine virtuali ha iniziato ad apparire nella rete. La tecnologia virtuale trasforma un server in più server logici, ogni macchina virtuale può funzionare in modo indipendente, ha il proprio sistema operativo, la propria APP, il proprio indirizzo MAC e indirizzo IP indipendenti e si connette all'entità esterna tramite lo switch virtuale (vSwitch) all'interno del server.

La virtualizzazione ha un requisito complementare: la migrazione in tempo reale delle macchine virtuali, ovvero la possibilità di spostare un sistema di macchine virtuali da un server fisico a un altro mantenendo il normale funzionamento dei servizi sulle macchine virtuali. Questo processo è indipendente dagli utenti finali: gli amministratori possono allocare in modo flessibile le risorse del server o riparare e aggiornare i server fisici senza compromettere il normale utilizzo da parte degli utenti.

Per garantire che il servizio non venga interrotto durante la migrazione, è necessario che non solo l'indirizzo IP della macchina virtuale rimanga invariato, ma anche che lo stato di esecuzione della macchina virtuale (ad esempio lo stato della sessione TCP) venga mantenuto durante la migrazione, in modo che la migrazione dinamica della macchina virtuale possa essere eseguita solo nello stesso dominio di livello 2, ma non attraverso la migrazione del dominio di livello 2. Ciò crea la necessità di domini L2 più grandi dal livello di accesso al livello core.

Il punto di demarcazione tra L2 e L3 nella tradizionale architettura di rete di livello 2 di grandi dimensioni si trova nello switch core, e il data center al di sotto dello switch core è un dominio di broadcast completo, ovvero la rete L2. In questo modo, è possibile gestire l'arbitrarietà dell'implementazione dei dispositivi e della migrazione delle posizioni, senza dover modificare la configurazione di IP e gateway. Le diverse reti L2 (VLan) vengono instradate attraverso gli switch core. Tuttavia, lo switch core in questa architettura deve mantenere un'enorme tabella MAC e ARP, il che impone requisiti elevati per la capacità dello switch core. Inoltre, lo switch di accesso (TOR) limita anche la scalabilità dell'intera rete. Questi, a loro volta, limitano la scalabilità della rete, l'espansione della rete e la sua elasticità; il problema del ritardo tra i tre livelli di scheduling non può soddisfare le esigenze aziendali future.

D'altro canto, il traffico est-ovest generato dalla tecnologia di virtualizzazione pone anche delle sfide alla tradizionale rete a tre livelli. Il traffico dei data center può essere ampiamente suddiviso nelle seguenti categorie:

Traffico nord-sud:Traffico tra client esterni al data center e il server del data center, oppure traffico dal server del data center a Internet.

Traffico est-ovest:Traffico tra server all'interno di un data center, nonché traffico tra data center diversi, come il disaster recovery tra data center e la comunicazione tra cloud privati e pubblici.

L'introduzione della tecnologia di virtualizzazione rende l'implementazione delle applicazioni sempre più distribuita e l'"effetto collaterale" è l'aumento del traffico est-ovest.

Le architetture tradizionali a tre livelli sono in genere progettate per il traffico Nord-Sud.Sebbene possa essere utilizzato per il traffico est-ovest, alla fine potrebbe non funzionare come previsto.

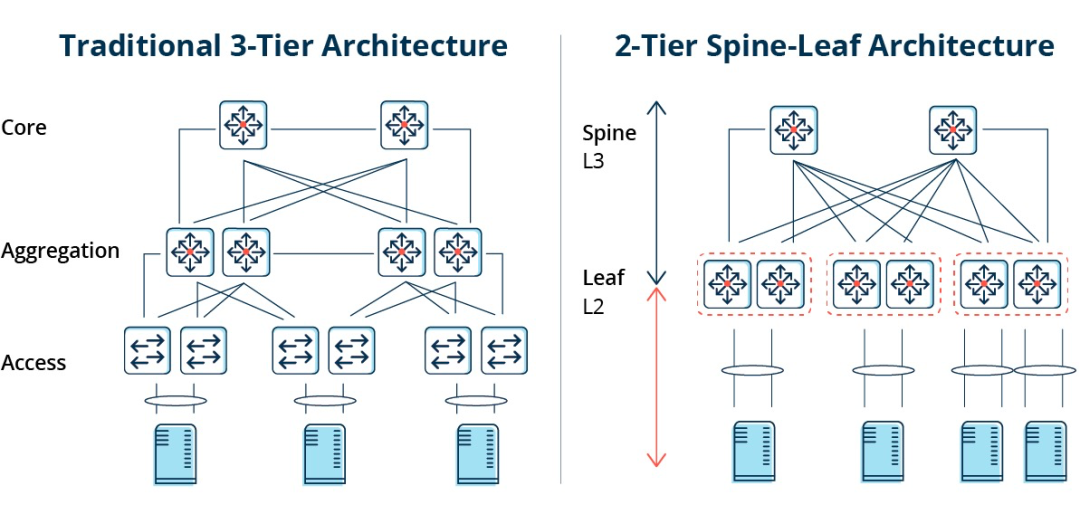

Architettura tradizionale a tre livelli vs. architettura Spine-Leaf

In un'architettura a tre livelli, il traffico est-ovest deve essere inoltrato attraverso dispositivi nei livelli di aggregazione e core, passando inutilmente attraverso molti nodi. (Server -> Accesso -> Aggregazione -> Switch Core -> Aggregazione -> Switch di accesso -> Server)

Pertanto, se una grande quantità di traffico est-ovest viene gestita tramite un'architettura di rete tradizionale a tre livelli, i dispositivi collegati alla stessa porta dello switch potrebbero competere per la larghezza di banda, con conseguenti tempi di risposta scadenti per gli utenti finali.

Svantaggi dell'architettura di rete tradizionale a tre livelli

Si può notare che la tradizionale architettura di rete a tre livelli presenta numerose carenze:

Spreco di larghezza di banda:Per evitare loop, il protocollo STP viene solitamente eseguito tra il livello di aggregazione e il livello di accesso, in modo che solo un uplink dello switch di accesso trasporti effettivamente il traffico e gli altri uplink vengano bloccati, con conseguente spreco di larghezza di banda.

Difficoltà nel posizionamento della rete su larga scala:Con l'espansione della scala di rete, i data center sono distribuiti in diverse posizioni geografiche, le macchine virtuali devono essere create e migrate ovunque e i loro attributi di rete, come indirizzi IP e gateway, rimangono invariati, il che richiede il supporto del fat Layer 2. Nella struttura tradizionale, non è possibile eseguire alcuna migrazione.

Mancanza di traffico est-ovest:L'architettura di rete a tre livelli è progettata principalmente per il traffico nord-sud, sebbene supporti anche il traffico est-ovest, ma i suoi limiti sono evidenti. Quando il traffico est-ovest è elevato, la pressione sugli switch del livello di aggregazione e del livello core aumenterà notevolmente, e le dimensioni e le prestazioni della rete saranno limitate al livello di aggregazione e al livello core.

Ciò fa sì che le aziende cadano nel dilemma tra costi e scalabilità:Il supporto di reti ad alte prestazioni su larga scala richiede un gran numero di apparecchiature di livello di convergenza e di livello core, il che non solo comporta costi elevati per le aziende, ma richiede anche una pianificazione anticipata della rete durante la sua costruzione. Quando la scala della rete è ridotta, si verifica uno spreco di risorse e, quando la scala della rete continua a espandersi, l'espansione diventa difficile.

L'architettura della rete Spine-Leaf

Che cos'è l'architettura di rete Spine-Leaf?

In risposta ai problemi sopra menzionati,è emersa una nuova progettazione di data center, l'architettura di rete Spine-Leaf, che chiamiamo rete Leaf Ridge.

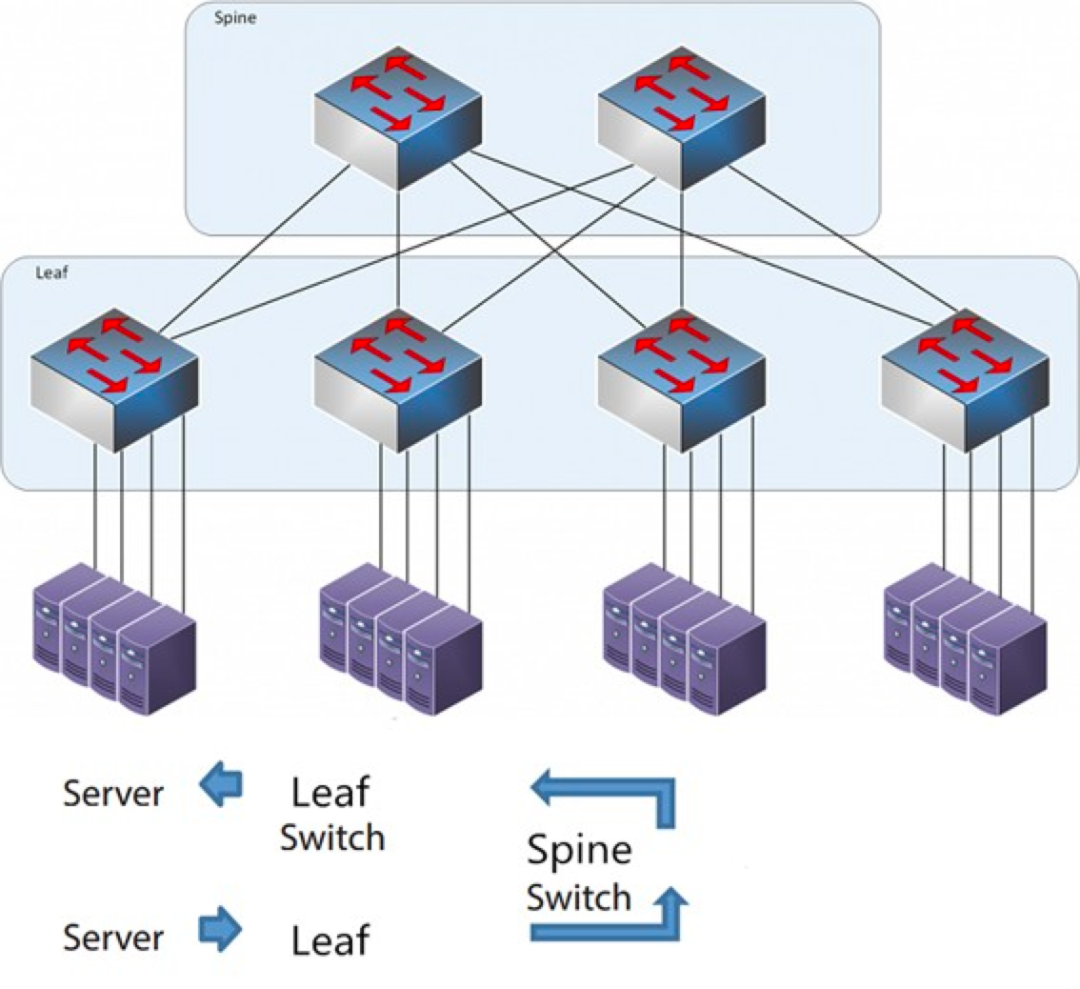

Come suggerisce il nome, l'architettura è composta da un livello Spine e da un livello Leaf, che includono gli switch Spine e Leaf.

L'architettura Spine-Leaf

Ogni switch leaf è collegato a tutti gli switch ridge, che non sono collegati direttamente tra loro, formando una topologia full-mesh.

Nella configurazione spine-and-leaf, una connessione da un server all'altro passa attraverso lo stesso numero di dispositivi (Server -> Leaf -> Spine Switch -> Leaf Switch -> Server), il che garantisce una latenza prevedibile. Infatti, un pacchetto deve attraversare solo uno spine e un altro leaf per raggiungere la destinazione.

Come funziona Spine-Leaf?

Leaf Switch: è l'equivalente dello switch di accesso nella tradizionale architettura a tre livelli e si connette direttamente al server fisico come TOR (Top Of Rack). La differenza con lo switch di accesso è che il punto di demarcazione della rete L2/L3 si trova ora sullo switch Leaf. Lo switch Leaf si trova al di sopra della rete a tre livelli e al di sotto del dominio di broadcast L2 indipendente, il che risolve il problema BUM della grande rete a due livelli. Se due server Leaf devono comunicare, devono utilizzare il routing L3 e inoltrarlo tramite uno switch Spine.

Switch Spine: equivalente a uno switch core. La tecnologia ECMP (Equal Cost Multi Path) viene utilizzata per selezionare dinamicamente più percorsi tra gli switch Spine e Leaf. La differenza è che lo Spine ora fornisce semplicemente una rete di routing L3 resiliente per lo switch Leaf, in modo che il traffico nord-sud del data center possa essere instradato dallo switch Spine anziché direttamente. Il traffico nord-sud può essere instradato dallo switch edge parallelo allo switch Leaf al router WAN.

Confronto tra l'architettura di rete Spine/Leaf e l'architettura di rete tradizionale a tre livelli

Vantaggi di Spine-Leaf

Piatto:Un design piatto accorcia il percorso di comunicazione tra i server, riducendo la latenza e migliorando significativamente le prestazioni delle applicazioni e dei servizi.

Buona scalabilità:Quando la larghezza di banda è insufficiente, l'aumento del numero di switch ridge può estendere orizzontalmente la larghezza di banda. Quando il numero di server aumenta, possiamo aggiungere switch leaf se la densità di porte è insufficiente.

Riduzione dei costi: traffico in direzione nord e sud, in uscita dai nodi foglia o dai nodi di cresta. Flusso est-ovest, distribuito su più percorsi. In questo modo, la rete di cresta foglia può utilizzare switch a configurazione fissa senza la necessità di costosi switch modulari, riducendo così i costi.

Bassa latenza e prevenzione della congestione:I flussi di dati in una rete Leaf Ridge hanno lo stesso numero di hop attraverso la rete, indipendentemente da origine e destinazione, e due server qualsiasi sono raggiungibili l'uno dall'altro tramite un percorso Leaf->Spine->Leaf a tre hop. Questo stabilisce un percorso di traffico più diretto, che migliora le prestazioni e riduce i colli di bottiglia.

Elevata sicurezza e disponibilità:Il protocollo STP viene utilizzato nella tradizionale architettura di rete a tre livelli e, in caso di guasto di un dispositivo, la riconvergenza influisce negativamente sulle prestazioni della rete o addirittura provoca il suo guasto. Nell'architettura leaf-ridge, in caso di guasto di un dispositivo, la riconvergenza non è necessaria e il traffico continua a passare attraverso altri percorsi normali. La connettività di rete non viene compromessa e la larghezza di banda viene ridotta di un solo percorso, con un impatto minimo sulle prestazioni.

Il bilanciamento del carico tramite ECMP è particolarmente indicato per ambienti in cui vengono utilizzate piattaforme di gestione di rete centralizzate come SDN. SDN consente di semplificare la configurazione, la gestione e il reindirizzamento del traffico in caso di blocco o guasto del collegamento, rendendo la topologia full mesh con bilanciamento del carico intelligente un metodo relativamente semplice da configurare e gestire.

Tuttavia, l'architettura Spine-Leaf presenta alcune limitazioni:

Uno svantaggio è che il numero di switch aumenta le dimensioni della rete. Il data center dell'architettura di rete leaf ridge deve aumentare il numero di switch e apparecchiature di rete in modo proporzionale al numero di client. Con l'aumentare del numero di host, è necessario un numero elevato di switch leaf per l'uplink allo switch ridge.

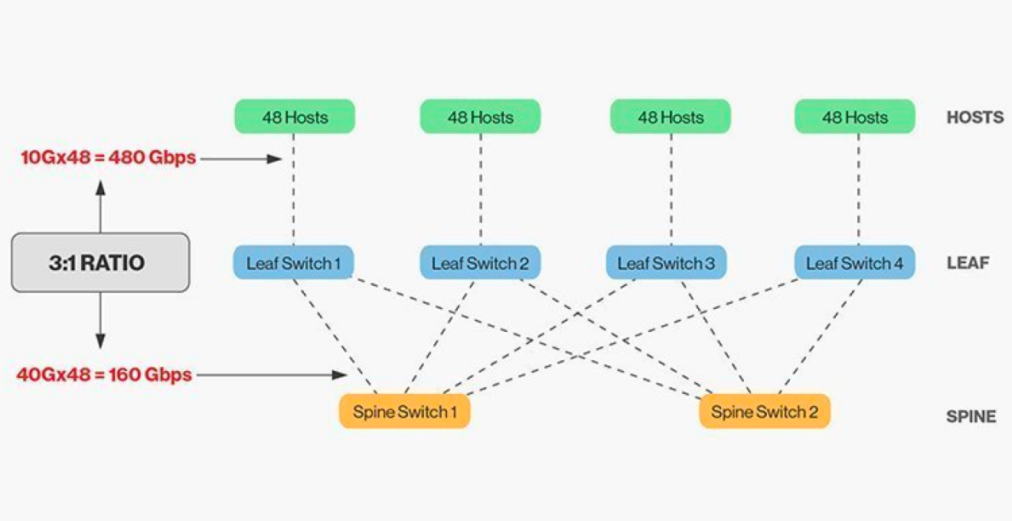

L'interconnessione diretta degli switch di cresta e di foglia richiede la corrispondenza e, in generale, il rapporto di larghezza di banda ragionevole tra switch di cresta e di foglia non può superare 3:1.

Ad esempio, ci sono 48 client con velocità di 10 Gbps sullo switch leaf con una capacità totale di porta di 480 Gb/s. Se le quattro porte uplink 40G di ogni switch leaf sono collegate allo switch ridge 40G, la capacità uplink sarà di 160 Gb/s. Il rapporto è 480:160, ovvero 3:1. Gli uplink dei data center sono in genere 40G o 100G e possono essere migrati nel tempo da un punto di partenza di 40G (Nx 40G) a 100G (Nx 100G). È importante notare che l'uplink dovrebbe sempre essere più veloce del downlink per non bloccare il collegamento delle porte.

Le reti Spine-Leaf hanno anche requisiti di cablaggio chiari. Poiché ogni nodo leaf deve essere collegato a ogni switch spine, è necessario posare più cavi in rame o fibra ottica. La distanza dell'interconnessione fa aumentare i costi. A seconda della distanza tra gli switch interconnessi, il numero di moduli ottici di fascia alta richiesti dall'architettura Spine-Leaf è decine di volte superiore a quello della tradizionale architettura a tre livelli, il che aumenta i costi complessivi di implementazione. Tuttavia, ciò ha portato alla crescita del mercato dei moduli ottici, in particolare per i moduli ottici ad alta velocità come 100G e 400G.

Data di pubblicazione: 26-01-2026